Accueil > Politique > Lavender, l’IA qui cible les Palestiniens (1ère partie)

Traduction d’AID pour Les-crises.fr n° 2024-042

Lavender, l’IA qui cible les Palestiniens (1ère partie)

Lavender, l’IA qui cible les Palestiniens (1ère partie)

Par Yuval Abraham, traduction par Jocelyne Le Boulicaut

mardi 23 avril 2024, par

AID soutient financièrement le très intéressant site "Les-crises.fr" depuis plusieurs années. Nous avons fait un pas de plus en participant aux traductions des textes anglais quand le site fait appel à la solidarité de ses adhérents. Nous avons donc mandaté une de nos adhérentes, Jocelyne LE BOULICAUT, enseignante universitaire d’anglais retraitée, pour y participer en notre nom et nous indemnisons son temps passé avec notre monnaie interne

Lavender, l’IA qui cible les Palestiniens (1ère partie)

Le 03 avril 2024 par Yuval Abraham

De la fumée s’élève après des frappes aériennes israéliennes à Beit Lahia, dans le nord de la bande de Gaza, le 28 décembre 2023 (Yonatan Sindel/Flash90)

De la fumée s’élève après des frappes aériennes israéliennes à Beit Lahia, dans le nord de la bande de Gaza, le 28 décembre 2023 (Yonatan Sindel/Flash90)

« Lavender » : Le système IA qui guide les bombardements israéliens à Gaza. L’armée israélienne a désigné des dizaines de milliers d’habitants de Gaza comme cibles à assassiner, en utilisant un système de ciblage par IA avec peu de contrôle humain et en adoptant une approche laxiste en matière de pertes humaines, révèlent +972 et Local Call.

En 2021, un livre intitulé "The Human-Machine Team : How to Create Synergy Between Human and Artificial Intelligence That Will Revolutionize Our World" (L’équipe humain-machine : comment créer une synergie entre l’intelligence humaine et l’intelligence artificielle qui révolutionnera notre monde) a été publié en anglais sous le pseudonyme de "Brigadier General Y.S."

Dans cet ouvrage, l’auteur - un homme dont nous pouvons confirmer qu’il est l’actuel commandant de l’unité d’élite du renseignement israélien 8200 - plaide en faveur de la conception d’une machine spéciale capable de traiter rapidement des quantités massives de données afin de générer des milliers de « cibles » potentielles pour des frappes militaires lorsque la guerre fait rage.

Une telle technologie, écrit-il, résoudrait ce qu’il décrit comme un « goulot d’étranglement humain tant pour la localisation de nouvelles cibles que pour la prise de décision pour approuver les cibles ».

Il s’avère qu’une telle machine existe vraiment. Une nouvelle enquête menée par+972 Magazine et Local Call révèle que l’armée israélienne a développé un programme basé sur l’intelligence artificielle, connu sous le nom de « Lavender » (Lavande), dévoilé ici pour la première fois.

Selon six officiers de renseignement israéliens, qui ont tous servi dans l’armée pendant la guerre actuelle contre la bande de Gaza et ont été directement impliqués dans l’utilisation de l’IA pour générer des cibles à assassiner, Lavender a joué un rôle clé dans le bombardement sans précédent de Palestiniens, en particulier pendant les premières phases de la guerre.

En fait, selon les sources, son influence sur les opérations militaires a été telle que celles-ci traitaient les données fournies par l’IA "comme s’il s’agissait de décisions d’origine humaine".

Officiellement, le système Lavender est conçu pour marquer comme cibles potentielles à bombarder tous les agents présumés appartenir aux ailes militaires du Hamas et du Jihad islamique palestinien (PIJ), y compris les moins gradés.

Des Palestiniens transportent les blessés et tentent d’éteindre un incendie après une frappe aérienne israélienne sur une maison dans le camp de réfugiés de Shaboura dans la ville de Rafah, au sud de la bande de Gaza, le 17 novembre 2023 (Abed Rahim Khatib/Flash90)

Des Palestiniens transportent les blessés et tentent d’éteindre un incendie après une frappe aérienne israélienne sur une maison dans le camp de réfugiés de Shaboura dans la ville de Rafah, au sud de la bande de Gaza, le 17 novembre 2023 (Abed Rahim Khatib/Flash90)

Les sources ont déclaré à +972 et à Local Call que, pendant les premières semaines de la guerre, l’armée s’est presque entièrement appuyée sur Lavender, qui a pointé jusqu’à 37 000 Palestiniens comme militants présumés - ainsi que leurs maisons - en vue d’éventuelles frappes aériennes.

Au début de la guerre, l’armée a largement autorisé les officiers à adopter les listes d’objectifs de Lavender, sans exiger de vérification approfondie des raisons pour lesquelles la machine avait fait ces choix, ni d’examen des données brutes de renseignement sur lesquelles elles étaient basées.

Une source a déclaré que le personnel se contentait bien souvent d’entériner les décisions de la machine, ajoutant que, normalement, seulement « environ 20 secondes » étaient consacrée à chaque cible avant l’autorisation de bombarder - il s’agissait seulement de s’assurer que la cible indiquée par Lavender était bien humaine.

Et ceci, tout en reconnaissant que dans environ 10% des cas le système commet ce que l’on considère comme des « erreurs », et peut occasionnellement pointer des individus qui n’ont qu’un lien ténu avec des groupes militants, voire aucun lien du tout.

En outre, l’armée israélienne a systématiquement attaqué les personnes ciblées alors qu’elles se trouvaient chez elles - généralement la nuit en présence de toute leur famille - plutôt qu’au cours d’une activité militaire.

Selon les sources, cela s’explique par le fait que, du point de vue du renseignement, il est plus facile de localiser les individus quand ils se trouvent à leur domicile privé.

Par ailleurs, d’autres systèmes informatiques de détection, dont celui appelé « Where’s Daddy ? » (Où est papa ?), dont on révèle ici pour la première fois l’existence ont été utilisés tout spécialement pour localiser les individus ciblés, les suivre et commettre des attentats à la bombe lorsqu’ils étaient entrés dans les résidences familiales.

Le résultat, comme en témoignent les sources, est que des milliers de Palestiniens - pour la plupart des femmes et des enfants ou des personnes qui n’étaient pas impliquées dans les combats - ont été éliminés par des frappes aériennes israéliennes, en particulier au cours des premières semaines de la guerre, en raison de décisions du programme d’IA.

Des Palestiniens attendent pour récupérer les corps de leurs proches qui ont été tués lors d’une frappe aérienne israélienne, à l’hôpital Al-Najjar à Rafah, dans le sud de la bande de Gaza, le 24 octobre 2023 (Abed Rahim Khatib/Flash90)

Des Palestiniens attendent pour récupérer les corps de leurs proches qui ont été tués lors d’une frappe aérienne israélienne, à l’hôpital Al-Najjar à Rafah, dans le sud de la bande de Gaza, le 24 octobre 2023 (Abed Rahim Khatib/Flash90)

« Tuer les agents [du Hamas] uniquement lorsqu’ils se trouvaient dans un bâtiment militaire ou qu’ils participaient à une activité militaire ne nous intéressait pas, a déclaré A., un officier de renseignement, à +972 et Local Call.

Bien au contraire, Tsahal les a bombardés dans leurs maisons sans aucune hésitation, en première intention. Il est beaucoup plus facile de bombarder une maison d’habitation. Le système est conçu pour les repérer quand ils sont dans cette situation là ».

Le système Lavender complète un autre système d’IA, « Habsora », (Evangile en français) dont le fonctionnement a été révélé lors d’une précédente enquête menée par +972 et Local Call en novembre 2023, et par les publications de l’armée israélienne elle-même.

La différence fondamentale entre les deux systèmes réside dans la définition de la cible : alors que Habsora pointe les bâtiments et les structures à partir desquels, selon l’armée, les militants opèrent, Lavender repère les personnes - et les fait figurer sur une liste de personnes à abattre.

De plus, selon les sources, lorsqu’il s’agissait de cibler des militants présumés de second rang, désignés par Lavender, l’armée privilégiait l’utilisation de missiles non guidés, communément appelés bombes « muettes » (par opposition aux bombes de précision « intelligentes »), qui peuvent faire s’écrouler des bâtiments entiers sur leurs occupants et causer de nombreuses pertes humaines.

« On n’a pas envie de gaspiller des bombes coûteuses pour des gens qui ne sont pas importants - cela coûte très cher au pays et il y a une pénurie [de ces bombes]", a déclaré C., l’un des officiers de renseignement.

Une autre source a déclaré avoir personnellement autorisé le bombardement de « centaines » de domiciles privés appartenant à des agents subalternes présumés indiqués par Lavender, le « dommage collatéral » en a été que nombre de ces attaques ont tué des civils et des familles entières.

Décision sans précédent, selon deux des sources, l’armée a également décidé, au cours des premières semaines de la guerre, que pour chaque agent subalterne du Hamas pointé par Lavender, il était acceptable de tuer jusqu’à 15 ou 20 civils ; par le passé, l’armée n’autorisait aucun « dommage collatéral » lors de l’assassinat de militants de second rang.

Des Palestiniens tentent de sauver des survivants et de retirer des corps des décombres après que des frappes aériennes israéliennes ont touché des bâtiments près de l’hôpital Al-Aqsa Martyrs à Deir al-Balah, au centre de Gaza, le 22 octobre 2023. (Mohammed Zaanoun/Activestills)

Des Palestiniens tentent de sauver des survivants et de retirer des corps des décombres après que des frappes aériennes israéliennes ont touché des bâtiments près de l’hôpital Al-Aqsa Martyrs à Deir al-Balah, au centre de Gaza, le 22 octobre 2023. (Mohammed Zaanoun/Activestills)

Les sources ont ajouté que, dans le cas où la cible était un haut responsable du Hamas ayant le rang de commandant de bataillon ou de brigade, l’armée a, à plusieurs reprises, autorisé le meurtre de plus de 100 civils pour l’assassinat d’un seul gradé.

Dans l’enquête qui suit, nous avons choisi de présenter les six étapes chronologiques du processus hautement automatisé employé par l’armée israélienne pour définir ses cibles au cours des premières semaines de la guerre de Gaza. Tout d’abord, nous décrivons le système Lavender lui-même, celui qui a désigné des dizaines de milliers de Palestiniens à l’aide de l’IA.

Ensuite, nous dévoilons le système "Where’s Daddy ?" (Où est papa ?), qui suivait ces cibles et signalait à l’armée qu’elles entraient chez elles. Enfin, nous expliquons comment le choix d’utiliser les bombes « muettes » se faisait afin de frapper ces maisons.

Quatrième point, nous expliquons comment l’armée a assoupli le nombre de civils pouvant être tués lors du bombardement d’une cible. En cinq, nous montrons que les logiciels automatisés calculent de manière inexacte le nombre de non-combattants dans chaque foyer.

En six, nous démontrons qu’à plusieurs reprises, lorsqu’une maison a été frappée, généralement la nuit, la cible individuelle n’était parfois même pas là, tout simplement parce que l’information n’avait pas été vérifiée en temps réel par les officiers de Tsahal.

ÉTAPE 1 : DÉFINITION DES CIBLES

’Une fois le système automatique lancé, le ciblage s’emballe’. Dans l’armée israélienne, l’expression « cible humaine » désignait autrefois un haut responsable militaire qui, selon les règles du Droit International des armées, pouvait être tué à son domicile privé, même s’il y avait des civils autour de lui.

Des sources de renseignement ont déclaré à+972 et à Local Call que lors des précédentes guerres d’Israël, étant donné qu’il s’agissait d’une manière « particulièrement brutale » de tuer quelqu’un - souvent en tuant toute la famille en même temps que la cible - ces cibles humaines étaient déterminées avec le plus grand soin et seuls les commandants militaires de haut rang étaient bombardés chez eux, afin de respecter le principe de proportionnalité en vertu du droit international.

Des destructions massives sont visibles dans le quartier populaire d’Al-Rimal de la ville de Gaza après qu’il ait été visé par des frappes aériennes menées par les forces israéliennes, le 10 octobre 2023. (Mohammed Zaanoun/Activestills)

Des destructions massives sont visibles dans le quartier populaire d’Al-Rimal de la ville de Gaza après qu’il ait été visé par des frappes aériennes menées par les forces israéliennes, le 10 octobre 2023. (Mohammed Zaanoun/Activestills)

Cependant, après le 7 octobre, lorsque les militants du Hamas ont lancé leur assaut meurtrier contre les communautés du sud d’Israël, tuant environ 1200 personnes et en enlevant 240, l’armée a adopté une approche radicalement différente, selon les sources.

Selon les sources, cela veut dire que le rôle du personnel dans l’incrimination des Palestiniens en tant qu’agents militaires a été mis de côté et que c’est l’intelligence artificielle qui a fait la majeure partie du travail à sa place.

Selon quatre des sources qui ont parlé à +972 et à Local Call, Lavender - qui a été développé pour générer des cibles humaines dans la guerre actuelle - a désigné pour être assassinés quelque 37 000 Palestiniens comme étant susceptibles d’être des « militants du Hamas », la plupart d’entre eux de rang inférieur (le porte-parole de Tsahal a nié l’existence d’une telle liste noire lors d’une déclaration faite à +972 et à Local Call).

« Nous ignorions complètement qui étaient ces agents novices dans la mesure où ils n’étaient pas régulièrement suivis par Israël [avant la guerre] », a expliqué l’officier supérieur B. à+972 et à Local Call, justifiant ainsi la raison pour laquelle ce système de ciblage particulier avait été développé pour la guerre en cours.

« Il fallait qu’on puisse attaquer automatiquement [les agents subalternes]. C’est le Saint Graal. Une fois automatisée, la définition des cibles s’emballe ».

Les sources ont indiqué que l’autorisation d’adopter automatiquement les listes de personnes à abattre générées par Lavender, qui n’avait auparavant été utilisé que comme outil auxiliaire, a été accordée environ deux semaines après le début de la guerre, après que le personnel des services de renseignement a vérifié « en manuel » le degré d’exactitude d’un échantillon aléatoire de plusieurs centaines de cibles sélectionnées par le système IA.

Lorsque ce contrôle a révélé que les résultats de Lavender avaient atteint une précision de 90% dans l’identification de l’affiliation d’un individu au Hamas, l’armée a autorisé l’utilisation généralisée du système.

Selon certaines sources, à partir de ce moment-là, si Lavender décidait qu’un individu était un militant du Hamas, on leur demandait en substance de considérer qu’il s’agissait d’un ordre, sans obligation de vérifier de manière indépendante pourquoi la machine avait fait ce choix ou d’examiner les données brutes de renseignement utilisées à cet effet..

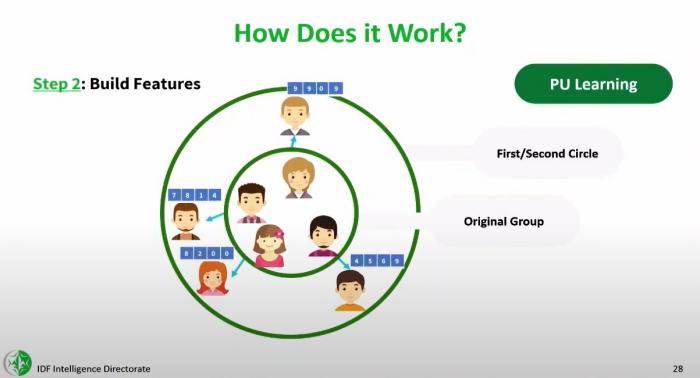

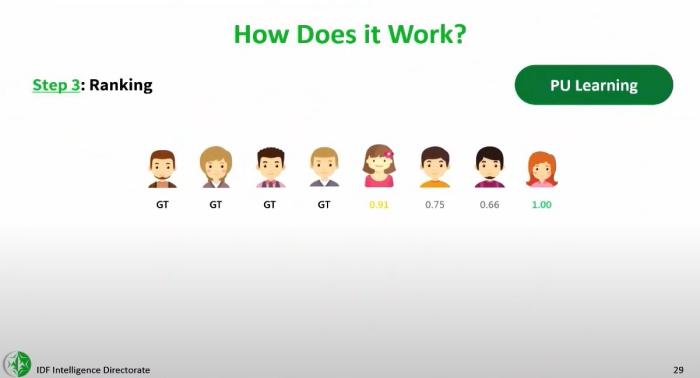

Diapositives d’une conférence donnée par le commandant du centre de science des données et d’intelligence artificielle de l’unité 8200 de Tsahal à l’université de Tel-Aviv en 2023, obtenues par +972 et Local Call.

Diapositives d’une conférence donnée par le commandant du centre de science des données et d’intelligence artificielle de l’unité 8200 de Tsahal à l’université de Tel-Aviv en 2023, obtenues par +972 et Local Call.

« À 5 heures du matin, [l’armée de l’air] arrivait et bombardait toutes les maisons que nous avions marquées, raconte B.. Nous avons éliminé des milliers de personnes. Nous n’avons pas procédé à une vérification individu par individu - nous avons tout mis dans des systèmes automatisés, et dès que l’une [des personnes marquées] était chez elle, elle devenait immédiatement une cible. Nous l’avons bombardé, lui et sa maison.

Le logiciel Lavender analyse les informations recueillies concernant la plupart des 2,3 millions d’habitants de la bande de Gaza grâce à un système de surveillance de masse, puis évalue et classe la probabilité que chaque personne soit active dans l’aile militaire du Hamas ou celle du Jihad Islamique Palestinien (JIP).

Selon certaines sources, l’IA attribue à la quasi-totalité des habitants de Gaza une note de 1 à 100, traduisant la probabilité qu’il s’agisse d’un combattant.

Des Palestiniens sur le site d’une frappe aérienne israélienne à Rafah, dans le sud de la bande de Gaza, le 24 février 2024. (Abed Rahim Khatib/Flash90)

Des Palestiniens sur le site d’une frappe aérienne israélienne à Rafah, dans le sud de la bande de Gaza, le 24 février 2024. (Abed Rahim Khatib/Flash90)

’Plus il y a d’informations, et plus elles sont diverses et mieux c’est’

Lavender apprend à reconnaître les caractéristiques des agents connus du Hamas et du JIP, données qui ont été transmises au système en tant que données du programme, et ensuite à repérer ces mêmes caractéristiques - également appelées « particularités » - au sein de la population générale, ont expliqué les sources.

Une personne présentant plusieurs particularités suspectes différentes atteindra un niveau élevé et deviendra ainsi automatiquement une cible potentielle à assassiner. Dans "The Human-Machine Team", le livre cité au début de cet article, le commandant actuel de l’unité 8200 plaide en faveur d’un tel système sans citer le nom de Lavender.

(Le nom du commandant lui-même n’est pas cité non plus, mais cinq sources au sein de l’unité 8200 ont confirmé qu’il en est l’auteur, comme l’a également rapporté Haaretz) .

Décrivant le personnel comme un « goulot » qui restreint la capacité de l’armée au cours d’une opération militaire, le commandant déplore : "Nous [humains] sommes incapables de traiter autant d’informations. Peu importe le nombre de personnes chargées de produire des objectifs pendant la guerre, on reste incapable de produire suffisamment d’objectifs chaque jour ».

« Grâce à ce système, nous avons réussi à identifier les commandants des unités de missiles du Hamas », a déclaré le colonel Yoav lors de la conférence, faisant allusion à l’opération militaire israélienne de mai 2021 à Gaza, au cours de laquelle la machine a été utilisée pour la première fois.

Sur les diapositives de la présentation, également obtenues par +972 et Local Call, figurent des illustrations du fonctionnement de la machine : elle est alimentée grâce aux données concernant les agents du Hamas existants, elle apprend à reconnaître leurs particularités, puis elle évalue d’autres Palestiniens en fonction de leur degré de ressemblance avec ces militants.

« Nous classons les résultats et déterminons le seuil [à partir duquel il convient d’attaquer une cible], a déclaré le colonel Yoav lors de la conférence, soulignant qu’en fin de compte, ce sont des personnes en chair et en os qui prennent les décisions. Dans le domaine de la défense, d’un point de vue éthique, nous insistons beaucoup sur ce point. Ces outils sont destinés à aider [les officiers de renseignement] à faire tomber leurs barrières ».

Des Palestiniens sur le site d’un bâtiment détruit par une frappe aérienne israélienne à Rafah, dans le sud de la bande de Gaza, le 18 mars 2024. (Abed Rahim Khatib/Flash90)

Des Palestiniens sur le site d’un bâtiment détruit par une frappe aérienne israélienne à Rafah, dans le sud de la bande de Gaza, le 18 mars 2024. (Abed Rahim Khatib/Flash90)

Dans la pratique, cependant, les sources qui ont utilisé Lavender au cours des derniers mois affirment que l’action humaine et la précision ont été remplacées par la création de cibles de masse et le caractère létal.

Des problèmes similaires se posent en ce qui concerne la capacité des machines à cibler quand il s’agit d’évaluer le téléphone utilisé par une personne désignée pour être assassinée.

« En temps de guerre, les Palestiniens changent de téléphone en permanence, explique la source. Les gens perdent le contact avec leur famille, donnent leur téléphone à un ami ou à une épouse, ou le perdent. Il est impossible de se fier à 100 % au mécanisme automatique qui détermine quel numéro de téléphone appartient à qui ».

Selon les sources, l’armée savait très bien que la supervision humaine minimale en vigueur ne permettrait pas de découvrir ces erreurs. Il n’y avait pas de politique « zéro erreur ». Les erreurs étaient traitées de façon statistique, a déclaré une source qui a utilisé Lavender.

En raison de la portée et de l’ampleur du projet, le protocole était le suivant : même si l’on n’est pas sûr que la machine a raison, on sait que statistiquement, elle est exacte. Alors, on fonce ».

« "Elle a fait ses preuves", a déclaré B., la source principale. Il y a quelque chose dans l’approche statistique qui vous impose une certaine norme et des critères. Lors de cette opération, le nombre d’attentats à la bombe dépasse l’entendement. De mémoire, c’est sans précédent. Et je fais bien plus confiance à un mécanisme statistique qu’à un soldat qui a perdu un ami deux jours plus tôt. Tout le monde, y compris moi, a perdu des gens le 7 octobre. La machine elle, a agi avec sang froid. Et c’est ce qui a rendu les choses plus faciles. »

Une autre source de renseignements, qui a soutenu la fiabilité des listes de suspects palestiniens établies par Lavender, a fait valoir que le temps d’un officier de renseignement ne valait la peine d’être investi que s’il s’agissait de vérifier l’information dans le cas où la cible était un commandant de haut rang au sein du Hamas.

« Mais s’il s’agit d’un militant subalterne, il est inutile des gaspiller temps et main-d’œuvre pour ça, a-t-il déclaré. En temps de guerre, on n’a pas le temps de vérifier chaque cible. On est donc prêt à assumer la marge d’erreur liée à l’utilisation de l’intelligence artificielle, à courir le risque de dommages collatéraux et la mort de civils, à envisager une attaque par erreur, et à s’en accommoder ».

Des Palestiniens émergent des décombres de maisons détruites par des frappes aériennes israéliennes dans la ville de Rafah, au sud de la bande de Gaza, le 20 novembre 2023. (Abed Rahim Khatib/Flash90)

Des Palestiniens émergent des décombres de maisons détruites par des frappes aériennes israéliennes dans la ville de Rafah, au sud de la bande de Gaza, le 20 novembre 2023. (Abed Rahim Khatib/Flash90)

B. a expliqué ce choix d’automatisation par le souci constant d’augmenter le nombre de cibles à assassiner. « Le jour où il n’y avait pas de cibles [dont l’évaluation des caractéristiques était suffisante pour autoriser une frappe], nous attaquions à un seuil plus bas.

On nous mettait constamment la pression : "Apportez-nous plus de cibles". On nous criait littéralement dessus. Nous avons fini [par tuer] nos cibles très rapidement ».

Il a ajouté qu’en fixant à Lavender un seuil d’évaluation plus bas, le système pointait davantage de gens comme cibles pour les frappes.

« Au pic de son fonctionnement, le système a réussi à générer 37 000 personnes comme cibles humaines potentielles, a déclaré B. Mais les chiffres changeaient tout le temps, parce que cela dépendait du seuil à partir duquel on définissait qui était un agent du Hamas ».

« À certains moments, un agent du Hamas était ainsi qualifié selon une définition plus large, puis la machine a commencé à nous fournir toutes sortes d’agents de la défense civile et de la police, pour lesquels il serait dommage de gaspiller des bombes. Ils aident le gouvernement du Hamas, mais ne mettent pas vraiment les soldats en danger ».

Une source qui a travaillé avec l’équipe militaire de science des données qui a entraîné Lavender a déclaré que les données collectées et concernant des employés du ministère de la sécurité intérieure dirigé par le Hamas, qui ne sont pas considérés comme des militants, ont également été introduites dans la machine.

Le fait que lors de l’entraînement de Lavender, le terme « agent du Hamas » ait été utilisé de manière vague et que des personnes travaillant pour la défense civile aient été incluses dans l’ensemble de données d’entraînement du système m’a réellement contrarié », a-t-il déclaré.

La source a ajouté que même si l’on pense que ces personnes méritent d’être tuées, le fait d’entraîner le système en fonction de leurs habitudes de communication rend Lavender plus susceptible de sélectionner des civils par erreur lorsque ses algorithmes sont appliqués à l’ensemble de la population.

« Comme il s’agit d’un système automatique qui n’est pas géré manuellement par des humains, les conséquences de cette décision sont dramatiques : cela signifie que de nombreuses personnes présentant des habitudes de communication civiles sont incluses comme cibles potentielles ».

’Nous nous sommes contentés de vérifier que la cible était un homme’.

L’armée israélienne rejette catégoriquement ces affirmations. Dans une déclaration à +972 et à Local Call, le porte-parole de Tsahal a nié utiliser l’intelligence artificielle pour incriminer des cibles, affirmant qu’il s’agit simplement de « dispositifs auxiliaires qui aident les officiers dans le processus d’incrimination ».

Le communiqué poursuit : « En tout état de cause, il est nécessaire de procéder à une vérification en toute indépendance réalisée par un analyste [du renseignement], qui s’assure que les cibles identifiées sont des cibles pouvant légitimement être attaquées, conformément aux dispositions prévues par les directives de Tsahal et par le droit international ».

Toutefois, des sources ont indiqué que le seul protocole de supervision humaine mis en place avant le bombardement de maisons de militants « de second rang » présumés pointés par Lavender consistait à effectuer une seule vérification : s’assurer que la cible sélectionnée par l’IA était bien un homme et non une femme.

L’armée partait du principe que si la cible était une femme, la machine s’était probablement trompée, car il n’y a pas de femmes dans les rangs des ailes militaires du Hamas et du JIP.

« Un être humain n’avait que quelques secondes seulement pour vérifier la cible », a déclaré B., expliquant que ce protocole avait été adopté après qu’il ait été observé que le système Lavender « faisait bien les choses » la plupart du temps.

« Au début, nous faisions des vérifications pour nous assurer que la machine ne se trompait pas. Mais à un moment donné, nous nous sommes fiés au système automatique et nous nous sommes contentés de vérifier que [la cible] était un homme - c’était suffisant. Il ne faut pas beaucoup de temps pour savoir si quelqu’un a une voix d’homme ou de femme ».

Pour effectuer cette vérification homme/femme, B. affirme que dans la guerre actuelle, « à cette étape, j’avais l’habitude de consacrer 20 secondes à chaque cible, et j’en faisais des dizaines chaque jour. En tant qu’être humain, ma valeur ajoutée était nulle, hormis le fait d’être un sceau d’approbation. Cela a permis de gagner beaucoup de temps. Si [la cible] était identifiée par le système robotisé et après vérification qu’il s’agissait bien d’un homme, la permission de bombarder était accordée, sous réserve toutefis de l’évaluation des dommages collatéraux. »

Dans la pratique, les sources ont déclaré que pour les civils pointés par erreur par Lavender, cela voulait dire qu’il n’y avait aucun mécanisme de supervision permettant de détecter l’erreur.

Selon B., il y a une erreur qui a été fréquente « si la cible [du Hamas] donne [son téléphone] à son fils, à son frère aîné ou à un homme au hasard. Cette personne sera bombardée dans sa maison avec sa famille. Cela s’est souvent produit. Voilà les principales erreurs dues à Lavender », a déclaré B.

Version imprimable :

AID Association Initiatives Dionysiennes

AID Association Initiatives Dionysiennes